논문의 핵심 내용 한줄 요약

LLM으로 추천 시스템을 구축해보자!

https://arxiv.org/abs/2203.13366

Recommendation as Language Processing (RLP): A Unified Pretrain, Personalized Prompt & Predict Paradigm (P5)

For a long time, different recommendation tasks typically require designing task-specific architectures and training objectives. As a result, it is hard to transfer the learned knowledge and representations from one task to another, thus restricting the ge

arxiv.org

Abstract

기존 추천 시스템은 일반적으로 task-specific한 아키텍처, 학습 목표를 가지고 있기에 일반화 능력이 떨어졌다.

이러한 문제를 해결하기 위해 text-to-text 기반의 추천 프레임워크인 P5를 제시했다.

P5에서는 user-item interactions, user descriptions, item metadata, user reviews와 같은 정보들이 모두 자연어 형태의 시퀀스로 변환해 사전학습을 진행한다.

따라서 다양한 다운스트림 추천 태스크의 기초 모델 역할을 할 수 있으며, 다른 양식과 쉽게 통합할 수 있고, 프롬프트에 기반한 추천이 가능하다.

1. Introduction

추천 시스템의 발전

초기의 추천 시스템은 로지스틱 회귀, 협업 필터링을 채택해 User - Item Interaction 기록을 활용해 사용자의 행동 패턴을 모델링했고, 이후 보다 고도화된 factorization machine, GBDT 모델을 통해 User profile, item metadata와 같은 맥락적 특징을 반영할 수 있었다.

최근에는 심층 신경망 모델을 통해 더욱 다양하고 정교한 특징들을 학습할 수 있게 되어, representation ability가 더욱 향상되었다.

다양한 추천 시스템 태스크

추천 시스템은 고전적인 rating prediction이나 user-item matching에 이어 sequential recommendation, conversational recommendation, explainable recommendation 등 새로운 태스크로 스펙트럼을 넓혀가고 있다.

최근에는 이러한 여러 추천 작업을 jointly하게 학습해, transferable representations를 얻는 연구 트렌드가 보인다.

그러나 기존의 추천 시스템과의 성능 격차가 있기에, 다양한 기능과 다양한 유형의 작업을 수용할 수 있는 포괄적인 추천 시스템의 필요성은 여전히 존재한다.

따라서 더 많은 추천 작업을 프레임워크로 통합하고, transferable representations를 학습할 수 있는 P5 패러다임을 제안하고자 한다.

“Pretrain, Personalized Prompt & Predict Paradigm” (denoted as P5)

P5에서는 추천 태스크를 프롬프트 기반 자연어 태스크로 formulate해 여러 추천 관련 작업을 함께 학습하며, 다음과 같은 이점을 가진다.

- 개인화된 프롬프트를 이용해 모든 추천 태스크를 NLP 태스크로 재구성한다.

자연어 템플릿으로 다양한 종류의 기능을 표현할 수 있기 때문에 task-specific encoder를 설계할 필요가 없다 - P5는 여러 추천 태스크를 text-to-text encoder-decoder 아키텍처에 통합하고, task-specific한 아키텍처나 목적 함수를 설계하는 대신 동일한 Language Modeling Loss로 훈련한다.

즉, P5는 모든 태스크를 conditional text generation problem으로 취급한다. - instruction-based prompt로 훈련된 P5는 unseen contents에도 충분한 zero-shot 성능을 달성, generalization이 뛰어나다고 볼 수 있다.

실험에서는 총 5개의 추천 태스크에 대해 P5의 zero-shot generalization ability를 테스트한다.

2. Related Work

Unified Frameworks

많은 선행 연구들은 다양한 작업을 통합된 모델에서 해결하고자 했다.

- T5, GPT-3 : text2text encoder-decoder 프레임워크와 autoregressive modeling을 통해 NLP 다운스트림 작업을 통합

- 이에 따라 다양한 태스크를 모두 자연어 형식으로 표현하는 연구들이 등장

- 그러나 기존 연구에서는 '개인화'가 고려되지 않음

- 최근 연구에서는 다운스트림 태스크로 쉽게 transfer 가능한 universal user representation을 학습하려고 시도

-> 여전히 다운스트림 데이터셋에 대한 추가적인 fine-tuning이 필요함 - P5는 이와 대조적으로 개인화를 transformer에 적용했기에, 자연스럽게 개인화를 필요로 하는 태스크에 일반화할 수 있음

Prompt Learning

- GPT-3의 성공은 NLP 태스크에서 프롬프트가 대중화되기 시작한 계기가 됨

- "pre-train, prompt, predict" 패러다임에 따라 많은 프롬프트 설계 방법이 등장

- discrete prompt

- continuous vector embedding prompt

- instruction-based prompt는 상세한 태스크 설명을 포함하고, 인간이 서로 소통하는 방식에 가깝기 때문에 범용 NLP 시스템의 유망한 방식이라고 여겨짐

- FLAN, T0 : 사람이 읽을 수 있는 프롬프트를 통해 구두화된 대규모 NLP 데이터셋으로 pre-trained LM을 finetuning

- 이러한 multi-task prompt based tuning은 unseen dataset에서도 강력한 zero-shot 성능을 보여줌

이에 영감을 받아 "collection of personalized prompts"를 생성한 다음, 구축된 개인화 프롬프트에 따라 구두화된 다양한 추천 태스크에 대해 seq2seq 모델을 훈련한다.

NLP for Recommendation

추천 시스템은 이전부터 NLP 기술과 상호작용 해왔다.

- explainable recommendation

NLP 모델이 주어진 추천에 대한 텍스트 설명을 생성하는 데 도움을 줌 - sequential recommendation as language modeling

User interaction history를 word token sequence로 사용 - text feature extraction

추천 성능을 향상시킬 수 있는 유익한 text encoding 추출 - conversational recommendation

사용자의 의도를 추론해 대화형식으로 추천을 제공

Zero-shot and Cold Start Recommendation

추천 시스템 성능은 사용 가능한 학습 데이터에 크게 의존하지만, 기록이 극히 제한적인 zero-shot 사례는 항상 존재한다.

이러한 cold start 경우에도 좋은 성능을 보이려면 우수한 일반화 능력을 가진 추천 모델을 사용해야 한다.

3. Personalized Prompt Collection

추천을 위한 multi-task prompt based pretraining을 용이하게 하기 위해 personalized prompt collection을 만들었다.

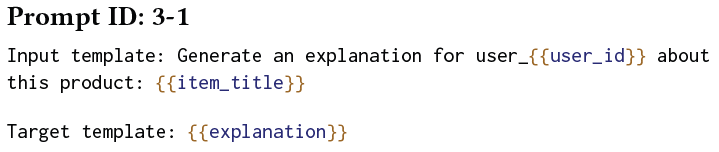

각 프롬프트는 input template, target template, associated metadata collection으로 구성되는데, 이 연구에서는 "Personalized prompt"를 다양한 user, item에 대한 personalized field를 포함하는 프롬프트로 정의한다.

예를 들어, User perference는 ID 번호를 통해 표시될 수도 있고, 이름, 성별, 나이와 같은 사용자에 대한 설명을 통해서도 표시될 수 있다.

item field 역시 ID 번호, 혹은 item에 대한 자세한 설명이 포함된 metadata를 통해 나타낼 수 있다.

prompt collection은 아래 5가지 추천 태스크를 포함한다.

- rating prediction

- sequential recommendation

- explantion

- review

- direct recommendation

각 태스크에 따른 프롬프트 설계 방식을 알아보자.

Rating prediction

3가지 타입의 프롬프트를 생성

- User, item에 대한 정보를 제공하고, 바로 rating score (1~5점)를 예측

- User가 item에 주어진 점수를 매길지 아닐지 예측 (yes/no)

- User가 item을 좋아할 지 / 싫어할 지 예측

별점이 4점보다 크면 User가 좋아하는 것이라 판단

그보다 낮을 경우에는 User가 싫어하는 것이라 판단

프롬프트 예시

Sequential recommendation

3가지 타입의 프롬프트를 생성

- User interaction history를 바탕으로 다음 item을 직접 예측

- User interaction history가 주어졌을 때, 후보 목록에서 가능한 다음 item을 선택

(전체 후보 목록 중 1개만 positive) - User interaction history를 바탕으로 주어진 item에 대해 User가 다음에 상호작용할 지 예측

프롬프트 예시

Explanation

주어진 item에 대한 User preference를 뒷받침하기 위한 텍스트 설명을 생성하도록 요청

2가지 타입의 프롬프트를 생성

- User/Item 정보가 포함된 설명 문장을 직접 생성

- feature word를 힌트로 해 설명 문장 생성

(리뷰 제목, 별점과 같은 다른 보조 정보가 포함될 수 있음)

프롬프트 예시

Review

2가지 타입의 프롬프트를 생성

- 리뷰 댓글을 짧은 리뷰 제목으로 요약

- 주어진 리뷰 댓글을 기반으로 해당 평점을 예측

프롬프트 예시

Direct recommendation

2가지 타입의 프롬프트를 생성

- User에게 item을 추천할 지 여부 예측 (yes / no)

- 후보 목록에서 User에게 추천할 가장 적절한 item을 선택

프롬프트 예시

프롬프트를 사용해 raw data에서 input - target 쌍을 직접 구축할 수 있으며, 프롬프트별 zero-shot test를 생성할 수 있다.

이 때 rating prediction, review, explanation은 동일한 raw data를 공유하지만 directional recommendation, sequential recommendation은 interaction history를 입력 정보로 사용한다는 점에서 차이가 있다.

사전 학습에서는 서로 다른 태스크의 input-target 쌍을 혼합해 학습 데이터로 사용하는데, robustness와 zero-shot generalization 향상을 위해 각 태스크에서 일부만 샘플링하여 사용한다.

특히 sequential, direct recommendation에서는 후보 목록을 채우기 위해 negative item group을 랜덤하게 선택해서 채운다. -> 실험 파트에서 후술

이렇게 개인화된 프롬프트 컬렉션을 사용하면 다양한 추천 관련 작업을 포괄하는 대량의 사전 학습 데이터를 편리하게 생성할 수 있으며, 자연어 프롬프트 템플릿으로 인해 모든 데이터는 input-target sequence의 통일된 형식을 공유하므로, 서로 다른 작업 간의 경계를 허물 수 있다.

또한 사전학습 과정을 통해 얻어진 지식으로 zero-shot에서도 좋은 generalization 성능을 보이게 할 수 있을 것이다.

4. The P5 Paradigm and Model

4.1 P5 Architecture

P5는 Encoder-Decoder framework (transformer) 를 바탕으로 구축되었다.

- Encoder에 Embedding을 넣기 전, positional encoding P를 추가

- input sequence에 포함된 개인화 정보를 모델이 인식하도록 하기 위해, subword token이 동일한 원래 단어에서 나온 것인지 여부를 표시하는 whole-word embedding W 추가

- 예를 들어 "item_7391"의 경우, SentencePiece tokenizer에 의해 "item", "_", "73", "91" 과 같은 방식으로 나누어짐

- 이를 하나의 whole word embedding (w10) 으로 나타내면, 개인화된 정보를 더 잘 인식할 수 있음

또 다른 방법은 각 User/item을 독립적인 추가 토큰으로 표현하는 것이지만, User와 Item의 수가 많을 경우 엄청난 양의 추가 토큰이 발생할 수 있다

- 3개의 Embedding (Token, Position, Whole-word) 를 모두 더해서 text embedding t를 구함

- Decoder는 이전에 생성된 토큰, Encoder output t를 가지고 미래 토큰의 확률 분포 예측 (Autoregressive)

- 사전 학습에서 P5는 입력 x를 조건으로 한 레이블 y의 negative log likelihood를 최소화하면서 모델 파라미터 \(\theta\)를 end-to-end로 학습

4.2 Recommendation with Pretrained P5

- rating, explanation, review : greedy decoding을 사용해 답 생성

- sequential, direct recommendation : target output으로 item list를 요구함

- sequential recommendation : beam search 사용해 잠재적인 다음 item 목록을 생성

- direct recommendation : candidate set S = {s_1, ... s_m} 에서 다음 추천 item을 예측

- 이 때 m개의 후보군 중 1개만 positive

- beam search를 사용해 가장 높은 점수를 받은 잠재적 target item 목록을 decoding한 후 평가를 수행

B = beam size, C : output item list

5. Experiments

다음과 같은 research questions에 답하고자 실험 및 ablation study를 진행했다.

- RQ1: 통합 프레임워크(P5)가 개별 모델에 비해 더 좋은 성능을 발휘하는가?

- RQ2 : unseen data에서도 잘 동작하는가? 즉, zero-shot generalization 성능이 뛰어난가?

- RQ3 : 모델 크기, task 개수, 프롬프트 수와 같은 요소가 P5에 어떤 영향을 미치는가?

- RQ4 : Personlized prompt를 위하여 각 User, Item에 대해 1. 독립적인 추가 토큰 추가 (e.g. <user_23> / 2. subword tokenize (e.g. “user”, “_”, “23”) 중 어떤 게 더 나은가?

- RQ5 : P5가 사전학습을 수행하는 데 얼마나 걸리는가? inference 는 얼마나 걸리나?

5.1 Experimental Setup

Datasets

- Amazon : 아마존 플랫폼에서 29개 카테고리 상품에 대한 User rating, reviews

- 본 실험에서는 3가지 카테고리 (Sports & Outdoors, Beauty,Toys & Games) 에 대해서만 실험을 진행

- Yelp : business recommendation을 위한 User rating, reviews

- 이전 연구1의 처리 방식을 따름

- 2019년의 거래 기록만을 사용

Task splits

- training (80%) / validation (10%) / test (10%)

- 각 user/ item에 대해 최소 1개 이상의 instance는 training set에 포함

- ground-truth explanation을 얻기 위해 Sentires toolkit 을 사용해 item feature word를 추출하고, review에서 1개 이상의 item feature word가 포함되어 있는 문장을 추출하여 User preference explanation으로 사용

- Sequential recommendation : user interaction sequence에서 마지막 항목은 test data, 마지막 바로 앞의 항목은 validation, 나머지 데이터는 train으로 사용

Implementation Details

- 사전학습된 T5 checkpoint를 backbone 모델로 사용

- SentencePiece tokenizer

- AdamW optimizer

- 10 epochs

- max lr : 10^-3

- input length : 512

- P5-small (P5-S)

- Encoder & Decoder : 6 layers

- head : 8 / d : 512

- batch size : 16

- total parameters : 60M

- P5-base (P5-B)

- Encoder & Decoder : 12 layers

- head : 12 / d : 768

- batch size : 32

- total parameters : 223M

- zero-shot 평가를 위해 각 작업 그룹의 마지막 프롬프트 사용 / 나머지는 모두 사전 학습에 활용

- rating : 정수 점수를 부동 소수점 숫자로 변환하기 위해 가우시안 샘플링을 사용

-> 점수 클래스 개수를 (5 -> 41) 로 늘림

-> 제한된 점수 유형으로 인한 overfitting을 피할 수 있다고 함 - Sequential recommendation : B = 20

- Direct recommendation : B = 20

- candidate set (100 items)

- User와 상호작용하지 않은 99개의 negative items

- 실제 상호작용한 1개의 positive item

- candidate set (100 items)

Metric

- rating : RMSE, MAE

- sequential & direct recommendation : HR@1, 5, 10, NDCG@5, 10

- explanation, review : BLEU-4,ROUGE-1, ROUGE-2, ROUGE-L

RMSE, MAE는 낮을수록 좋은 성능을 나타내며, 나머지 모든 지표는 높을수록 좋은 성능을 나타낸다.

HR@K / NDCG@K

추천 시스템에서 사용되는 대표적인 Ranking 기반 성능 평가 방법

HR@K (Hit Rate)

Hit Rate는 전체 사용자 수 대비 적중한 사용자 수를 의미한다(적중률).

Hit Rate는 아래 4가지 단계로 구할 수 있다.

1) 사용자가 선호한 아이템 중 1개를 제외한다.

2) 나머지 아이템들로 추천 시스템을 학습한다.

3) 사용자별로 K개의 아이템을 추천하고, 앞서 제외한 아이템이 포함되면 Hit이다.

4) 전체 사용자 수 대비 Hit한 사용자 수 비율을 구하면 Hit Rate가 된다.

NDCG@K (Normalized Discounted Cumulative Gain)

Top K개 아이템을 추천하는 경우, 추천 순서에 가중치를 두어 평가한다.

-> MAP는 사용자가 선호한 아이템이 추천 리스트 중 어떤 순서에 포함되었는지 여부에 대해서 1 or 0으로만 구분하지만, NDCG@K는 순서별로 가중치 값(관련도, relevance)을 다르게 적용하여 계산한다.

NDCG@K값은 1에 가까울수록 좋다.

5.2 Baselines for Multiple Tasks

Rating Prediction and Direct Recommendation

모델이 사용자 선호도에 부합하는 정확한 평점 / 추천 목록을 제공할 수 있는지를 검증

<Rating Prediction>

<Direct Recommendation>

Sequential Recommendation

- Caser7 : Sequential recommendation을 Markov chain으로 간주하고, CNN을 사용해 사용자 관심사를 모델링

- HGN8 : user behaviors의 long / short terms를 학습하기 위한 hierarchical gating networks

- GRU4Rec9 : 원래 세션 기반 추천을 위해 만들어짐. GRU를 사용해 사용자 클릭 기록 시퀀스를 모델링

- BERT4Rec10 : BERT 스타일 MLM을 모방해 추천을 위한 bidirectional representation을 학습

- FDSA11 : self-attention을 통해 feature transition pattern에 집중

- SASRec12 : self-attention, markov chain과 RNN approach를 모두 이용

- S^3Rec13 : self supervised objective를 활용해 item과 item attributes 사이의 상관관계를 더 잘 발견할 수 있도록 함

Explanation Generation

- Attn2Seq14 : attributes를 벡터로 encode하는 방식을 학습한 후 attention 메커니즘을 호출해 attribute vector를 조건으로 둔 review를 생성

- NRT15 : GRU를 활용해 User & Item ID를 기반으로 설명을 생성

- PETER, PETER+16 : transformer attention mask를 활용해 User & Item ID를 기반으로 설명을 생성

+에서는 hint feature word를 사용해 설명 생성을 도움

Review Related

- T017

- GPT-2 (리뷰 선호도 예측은 불가, 리뷰 요약에서만 사용)

5.3 Performance Comparison on Different Task Families (RQ1)

- Prompt 1-10,Prompt 2-13, Prompt 3-12, Prompt 4-4, Prompt 5-8 는 zero-shot evaluation을 위해 학습에 사용하지 않음

- seen prompt (보라색) / unseen prompt (주황색) 에 대해서 모두 형가를 수행

- seen prompt에서는 P5-B가 MF에 비해서 3개 데이터셋 모두 더 나은 MAE, RMSE를 보임

- unseen prompt에서는 P5-B와 MF가 비슷한 성능을 보임

- P5-S는 일반적으로 MAE는 좋지만 RMSE가 높은데, 이는 rating task의 작업 복잡도가 다른 추천 태스크에 비해 상대적으로 낮기 때문에 overfitting 되었다고 판단

- seen / unseen 둘 다 상대적으로 큰 격차로 다른 베이스라인 성능을 능가

-> P5 + beam search를 통한 다음 항목 예측이 효과적 - "Toys" 카테고리에서는 P5-S가 오히려 P5-B보다 나은 성능을 보이기도 함

- 3-3은 힌트 단어를 제공하지 않고 직접 설명을 생성하는 데 사용됨

P5가 모든 베이스라인 중 가장 우수한 성능을 보임 - 힌트 단어가 제공된 3-9, 3-12의 경우 대부분의 베이스라인보다 뛰어남

- P5-S가 "Beauty", "Toys"에서 더 좋은 성능을 보임

- "Beauty", "Toys" 데이터셋에서 P5-S가 T0, GPT-2의 성능을 뛰어넘음

- GPT-2, T0이 각각 1.5B, 11B 파라미터를 가지고 있는 것과 비교했을 때, 이는 괄목할만한 성과

P5는 훨씬 작은 사이즈(60M / 223M) 로도 좋은 성능을 달성

- discriminative prompt 5-1, 5-4의 경우 "yes"의 softmax generation probability를 이용해 후보군 아이템들을 순위 매김

- open question prompt 5-5, 5-8에서는 beam search를 이용해 top-k list를 생성함

- P5가 BPR 모델 성능을 뛰어 넘음

- SimpleX와 비교했을 때, 특히 상위 1순위 (HR@1)에서 잘 작동하며 2배 이상 우수함

5.4 Zero-shot Generalization to Unseen Prompts and Items in New Domain (RQ2)

5.4.1 Transfer to Unseen Personalized Prompts

앞선 5.3 섹션에서 보인 바와 같이, P5는 unseen prompt에서도 우수한 성능을 보였다.

이러한 결과는 multitask prompt 사전학습을 통해 P5가 문구 변형이 있는 unseen prompt를 이해할 수 있을만큼 성능이 강력해짐을 의미한다.

5.4.2 Transfer to Items in New Domain

zero shot transfer 난이도를 높여보자.

1개 도메인에서 사전학습된 P5-B에게 새 product domain으로 item field가 채워진 task family Z의 unseen prompt를 제시한다.

예를 들어, "Toys" 에 대해 사전학습된 P5 모델에게 "Beauty" 도메인의 items에 대한 기존 사용자의 선호도에 대해 질문하는 방식이다.

6가지 모든 경우의 수 ("Toys" -> "Beauty", "Sports" / "Beauty" -> "Toys", "Sports" / "Sports" -> "Beauty", "Toys") 에 대해서 실험을 진행했다.

- rating prediction (z-2 & z-3), like/dislike prediction (z-1 & z-4), explanation with feature word (z-6) 는 충분히 좋은 성능을 보임

- 이에 반해 explanation without feature words (Z-5 & Z-7) 는 성능이 현저히 떨어지는 것을 볼 수 있는데, 이는 새로운 도메인에 대한 관련 지식이 매우 부족한 어려운 태스크이기 때문

5.5 Ablation on Model Size (RQ3)

다양한 추천 태스크에서 모델 자체의 크기가 P5 예측 성능에 얼마나 큰 영향을 미치는지를 확인해보자.

P5-S (60M), P5-B (223M) 를 실험했는데, P5-S는 P5-B 모델에 비해 1/4 크기임에도 불구하고, 몇몇 개의 태스크와 데이터셋에서는 오히려 성능이 더 뛰어난 것을 보였다.

5.6 Ablation on Task Scaling (RQ3)

참고 문헌

- Kun Zhou et al., 2020. S3-rec: Self-supervised learning for sequential recommendation with mutual information maximization [본문으로]

- Yehuda Koren et al., 2009. Matrix factorization tech- niques for recommender systems. [본문으로]

- Heng-Tze Cheng et al., 2016. Wide & deep learning for recommender systems. In Proceedings of the 1st workshop on deep learning for recommender systems. [본문으로]

- Steffen Rendle et al., 2009. BPR: Bayesian Personalized Ranking from Implicit Feedback. In Proceedings of the Twenty-Fifth Conference on Uncertainty in Artificial Intelligence (Montreal, Quebec, Canada) (UAI ’09). [본문으로]

- Heng-Tze Cheng et al. 2016. Wide & deep learning for recommender systems. In Proceedings of the 1st workshop on deep learning for recommender systems. [본문으로]

- Kelong Mao et al., 2021. SimpleX: A Simple and Strong Baseline for Collaborative Filtering. In Proceedings of the 30th ACM International Conference on Information & Knowledge Management. [본문으로]

- Jiaxi Tang and Ke Wang. 2018. Personalized top-n sequential recommenda- tion via convolutional sequence embedding. In Proceedings of the eleventh ACM international conference on web search and data mining [본문으로]

- Chen Ma, Peng Kang, and Xue Liu. 2019. Hierarchical gating networks for sequential recommendation. In Proceedings of the 25th ACM SIGKDD international conference on knowledge discovery & data mining. 825–833. [본문으로]

- Balázs Hidasi, Alexandros Karatzoglou, Linas Baltrunas, and Domonkos Tikk. 2016. Session-based Recommendations with Recurrent Neural Networks. In ICLR. [본문으로]

- Fei Sun, Jun Liu, Jian Wu, Changhua Pei, Xiao Lin, Wenwu Ou, and Peng Jiang. 2019. BERT4Rec: Sequential recommendation with bidirectional encoder rep- resentations from transformer. In Proceedings of the 28th ACM international conference on information and knowledge management [본문으로]

- Tingting Zhang et al., 2019. Feature-level Deeper Self-Attention Network for Sequential Recommendation. In IJCAI. [본문으로]

- Wang-Cheng Kang and Julian McAuley. 2018. Self-attentive sequential recom- mendation. In 2018 IEEE International Conference on Data Mining (ICDM) [본문으로]

- Kun Zhou et al., 2020. S3-rec: Self-supervised learning for sequential recommendation with mutual information maximization. In Pro- ceedings of the 29th ACM International Conference on Information & Knowledge Management [본문으로]

- Li Dong et al., 2017. Learning to generate product reviews from attributes. In EACL. [본문으로]

- Piji Li et al., 2017. Neural rating regression with abstractive tips generation for recommendation. In Proceed- ings of the 40th International ACM SIGIR conference on Research and Development in Information Retrieval [본문으로]

- Lei Li et al., 2021. Personalized Transformer for Ex- plainable Recommendation. In Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Confer- ence on Natural Language Processing [본문으로]

- Victor Sanh et al., 2022. Multitask Prompted Training Enables Zero-Shot Task Generalization. In International Conference on Learning Representations. [본문으로]